A/B testing : les règles à suivre pour optimiser son dispositif digital

C’est la hantise de tous les responsables digitaux, la phobie des webmarketeurs : les taux de conversion insatisfaisants, les taux d’ouverture et de clics décevants sur les newsletters, les CTA qui ne sont jamais cliqués … Alors on modifie des choses. Et bien trop souvent, les décisions sont basées sur des éléments subjectifs : « Je devrais changer la couleur de ce CTA » ou « Je suis sûr qu’à cet emplacement là le bouton serait plus visible et plus cliqué ».

On déplace les éléments de la page, on change le wording, les couleurs, sans trop savoir où on va … On choisit le dernier design à la mode… Et les résultats ne sont pas forcément meilleurs. Et parfois, on ne prend pas le temps de mesurer l’impact des modifications effectuées.

Pourquoi l’utilisateur n’a pas ouvert ou cliqué sur le mail ? Pourquoi n’est-il pas arrivé au bout du tunnel de conversion ? Pourquoi n’a-t-il pas fait ce qu’on attendait de lui ? Comment inverser la tendance ? Et si l’A/B testing pouvait apporter des réponses à toutes ces questions ?

Pourquoi faire de l'A/B testing ?

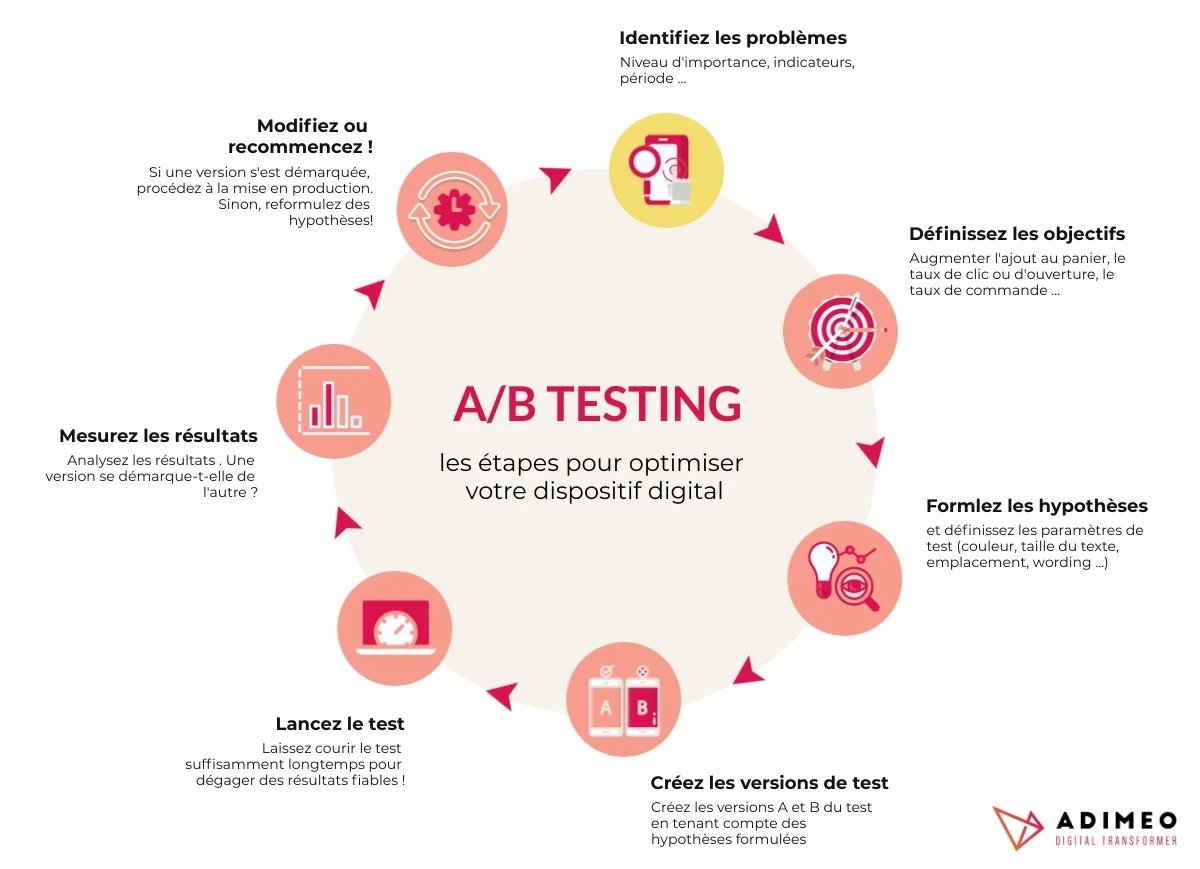

Petite définition rapide de l’A/B testing : il s’agit de comparer deux versions d’un même « objet » pour mesurer la performance d’une version par rapport à l’autre dans le but d’optimiser le dispositif digital sur la base de données statistiques et objectives.

L’A/B testing sert plusieurs objectifs :

- L’amélioration de l’expérience utilisateur,

- La génération de leads,

- L’augmentation des ventes pour un site e-commerce (appliquez l'A/B testing à votre site e-commerce !)

- …

La pratique de l’A/B testing s’inscrit dans une démarche agile d’optimisation continue du dispositif digital. Se remettre en question constamment. Remettre en question les choix éditoriaux et fonctionnels. Valider ou invalider des hypothèses. Cette technique a un avantage majeur : elle repose sur l’appréciation de l’utilisateur final. Les tests sont effectués directement auprès de la cible afin de dégager des résultats fiables, une base sûre pour la prise de décision.

L’A/B testing permet le contrôle des budgets marketing. Il s’agit d’investir du temps et de l’argent dans ce qui plait aux utilisateurs, ce qui leur est réellement utile. L’A/B testing est une pratique assez « marrante ». C’est l’occasion de tester des choses, laisser libre court à son imagination. Pour autant, pour recueillir des informations fiables et optimiser le ROI des campagnes, il faut suivre quelques règles !

Règle #1 : en A/B testing on peut tout tester, mais ...

Qu’est-il possible de tester avec l’A/B testing ? C’est très simple : tout !

Pour les emails et newsletters par exemple il est possible de tester l’objet du mail, le nom de l’expéditeur, les CTA et autres boutons, les visuels, les titres, le texte, les couleurs et même l’heure ou le jour d’envoi ! Mais il est inutile de perdre du temps à tout tester pour autant. Il faut d’abord se concentrer sur les choses qui ne fonctionnent pas.

Si le taux d’ouverture est bon mais le taux de clic mauvais, inutile de tester un changement d’objet ou d’expéditeur du mail… Le problème se situe plutôt sur un CTA par exemple : sa couleur, son emplacement, le texte …

Si les mails semblent déjà suffisamment performants, inutile de se lancer dans l’A/B testing tout de suite. Il faut concentrer les efforts là où ils sont utiles.

Et si les planning et budget le permettent, alors il est envisageable de réaliser des tests A/B sur des éléments qui fonctionnent déjà pour les améliorer encore.

Tout est une question de priorisation ! Quel est le gain estimé ? Les hypothèses envisagées sont-elles simples à mettre en place ? La page testée génère-t-elle suffisamment de trafic pour que le test soit intéressant ?

Règle #2 : tester un seul élément à la fois !

« J’ai changé la couleur et l’emplacement du bouton, comment savoir ce qui a fonctionné ? »

Et bien, ce n’est pas possible !

La règle d’or pour réussir les tests A/B : tester un seul élément à la fois !

On change d’abord la couleur. On analyse les résultats. On apporte les modifications, ou pas, selon les résultats. Puis on relance un deuxième test : on modifie cette fois l’emplacement. On analyse les résultats … et vous connaissez la suite. Chaque chose en son temps !

Règle #3 : bien choisir l’échantillon pour un test A/B fiable

La pertinence des résultats d’un test A/B repose sur la taille et la qualité de l’échantillon sur lequel il est mené. L’échantillon doit être représentatif de la cible, des utilisateurs visés.

Et pour des résultats fiables, il faut que l’échantillon soit suffisamment grand. Si l’A/B testing est mené auprès de 10 personnes seulement, les résultats ne pourront pas être fiables… Il faut obtenir suffisamment de résultats pour voir quelle version se démarque le plus.

Si le dispositif digital testé dégage suffisamment de trafic, atteindre un échantillon de taille suffisante ne devrait pas poser problème.

Si l’échantillon est trop petit, il faudra certainement l’étaler sur une plus longue durée pour avoir suffisamment de recul.

Pour un A/B testing efficace, il faut segmenter l’échantillon en deux audiences : une première audience reçoit la version A, la deuxième la version B. Pour que les résultats soient fiables, les audiences doivent être égales, tant par leur taille que par le profil des utilisateurs. Les deux versions doivent être diffusées dans les mêmes conditions pour chaque audience (audiences de taille identique, en même temps …)

Règle #4 : laisser tourner le test A/B suffisamment longtemps

Combien de temps doit durer un test A/B pour être fiable ? La durée du test est un élément essentiel pour garantir la fiabilité des résultats.

Il n’est pas rare que les résultats après modification/mise en production soient différents des résultats obtenus lors de l’expérimentation. Ce constat révèle une erreur durant la phase d’expérimentation : le test n’a pas été mené sur une durée assez longue pour recueillir des informations fiables.

Il est tentant d’arrêter le test dès qu’on remarque une différence notable entre deux versions. Pour autant, l’information recueillie n’est pas forcément représentative. Il arrive souvent que les résultats des deux versions finissent par être identiques alors qu’un écart notable a été remarqué quelques heures/jours plus tôt.

Il n’est pas possible de définir une durée de test par défaut.

La durée du test dépend de bien des éléments, notamment de la représentativité de l’échantillon, de sa taille et du timing ! En effet, les résultats peuvent varier selon l’heure ou le jour de la semaine. Reprenons l’exemple d’un test A/B sur un emailing. Si la cible visée est repartie sur différents fuseaux horaires le test ne doit pas être mené sur une trop courte durée.

Si le mail est envoyé à 16h, heure française, il y a peu de chance pour que les utilisateurs qui vivent aux USA interagissent avec le mail. Le décalage horaire implique que les utilisateurs américains reçoivent le mail à 1h du matin … Si le test est interrompu après 2h d’expérimentation par exemple, tout une partie de l’échantillon sera exclue de l’expérimentation et les résultats ne seront pas fiables.

Règle #5 : faire un suivi des optimisations

L’A/B testing est une stratégie de test sur le long terme.

Il est recommandé de faire un suivi des tests, optimisations et résultats associés si vous ne voulez pas répéter sans cesse les mêmes tests. C’est d’autant plus important si plusieurs personnes sont amenées à faire des tests séparément. Pourquoi tester un élément qui l’a déjà été ?

En matière d’A/B testing, le mot d’ordre est la patience ! Il est plus prudent de laisser courir un test quelques heures ou jours de plus en cas de doute. Arrêter le test trop tôt ne fait pas de gagner de temps. Au contraire ! Rejouer le test si les résultats ne sont pas fiables est bien plus chronophage.

Certaines expérimentations se révéleront décevantes. Vous testerez maintes modifications et vous ne verrez pas d’amélioration notable pour autant. Ça fait partie du jeu ! Il faudra parfois se montrer très patient avant de trouver la bonne combinaison.

Vous l’aurez compris : A/B testing rime avec « innovation incrémentale ». On améliore petit à petit le dispositif, étape par étape. De cette manière, la route est longue certes, mais les améliorations sont qualitatives. Et on est souvent surpris par l’impact que peut avoir un tout petit détail comme le wording ou la couleur d’un CTA 😀

9 minutes

9 minutes